| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 | 31 |

- aivle #에이블스쿨 #인공지능 #LSTM #GRU #CNN #RNN #NLP #자연어 #자연어처리 #AI #사각지능 #언어지능

- 제로초의자바스크립트입문

- 인공지능 #AI #aivle #에이블스쿨 #딥러닝 #머신러닝

- aivle #에이블스쿨 #인공지능 #AI #딥러닝 #CNN #머신러닝

- 딥러닝 #에이블스쿨 #aivle #인공지능 #AI #머신러닝

- 인공지능 #딥러닝 #에이블스쿨 #aivle #AI

- 길벗

- aivle #에이블스쿨 #AI #CNN #인공지능 #딥러닝 #머신러닝 #데이터증강

- 코딩자율학습단

- aivle #에이블스쿨 #인공지능 #AI #CNN #딥러닝 #머신러닝

- 인공지능 #AI #에이블스쿨 #aivle #딥러닝 #머신러닝

- aivle #에이블스쿨 #인공지능 #AI #딥러닝 #머신러닝

- aivle #에이블스쿨 #딥러닝 #머신러닝 #AI #머신러닝모델

- aivle #에이블스쿨 #인공지능 #AI #머신러닝 #딥러닝 #CNN

- 코딩자율학습단8기

- 나도코딩

- 제로초

- 에이블스쿨 #aivle #AI #인공지능 #딥러닝 #머신러닝 #RNN #LSTM #CNN #NLP #자연어 #자연어처리 #사각지능 #언어지능

- 스터디추천

- aivle #에이블스쿨 #인공지능 #AI #RNN #CNN #딥러닝 #NLP #자연어 #자연어처리 #머신러닝

- Today

- Total

jisoleil's coding good thing

딥러닝 2일차 본문

갈수록 어려워지는 딥러닝!

복잡하거나 헷갈리는 이론은 쓰고 자야겠다.

- 퍼셉트론

입력값- 순입력함수-활성함수-예측값

종류

- 단층 퍼셉트론

- 다층 퍼셉트론(ANN:인공신경망)

학습 알고리즘

Error가 발생한 데이터에 기반하여 W(가중치) 값을 기존에 새로운 W값으로 업데이트

한계

->오차정도 고려하지 않음

이후 학습률과 오차정도 고려

->학습률을 잘 설정할 것 그리고 임계값 설정

W+= 학습률* error Data *(임계값-출력값)

2. ANN(인공 신경망)

입력층+은닉층+출력층

한계

-> 학습 과정에서 파라미터 최적값 찾기 어려움

->overfiting 문제

->학습시간이 느리다.

3. DNN

은닉층 2개 이상

파생 CNN(정보추출, 문장분류, 얼굴인식),RNN

4. 오차역전파

오차를 점점 거슬러 올라가면서 다시 전파

- 순전파: Input ->output으로 w를 업데이트 하면서 활성화함수로 결과값 도출

- 역전파: 다시 역으로 input 방향으로 오차를 다시 보내며 가중치를 재업데이트함. 결과에 영향을 많이 미친 노드에 더 많은 오차 돌려줄것

은닉층의 활성화 함수는

activation='relu' 렐루 함수를 사용한다.

은닉층과 노드는 무슨 역활을 하는가?

-> 연결된 것으로부터 기존에 없던 새로운 feature 추출/ 재표현 하는 것

=>Feautre Representation(머신러닝과 딥러닝의 차이)

그리고 자주 쓰는 callback에서 자주 쓰는

early stopping(조기 종료)

: 과대 적합이 시작하기 전 훈련 종료

validation_splittraining set에서부터 알아서 분배해가져가는

큰일이다...

갈수록 어려워진다..

코딩은 비슷비슷 한 것 같은데...

이해하면서 코딩하기가 쉽지 않네..

인공지능을 공부한 내 친구가 머신러닝과 딥러닝 책을 나에게 빌려주었다..

그 친구에게 염치 없지만 그 책이 공부에 많은 도움이 되어 달라고 했고, 친구는 그 책 너에게 줄 생각이였다며 흔쾌히 책을 나에게 주었다.

그래서 내가 올~ 멋있는데 이제 다 이해한거야? 라고 말했었고

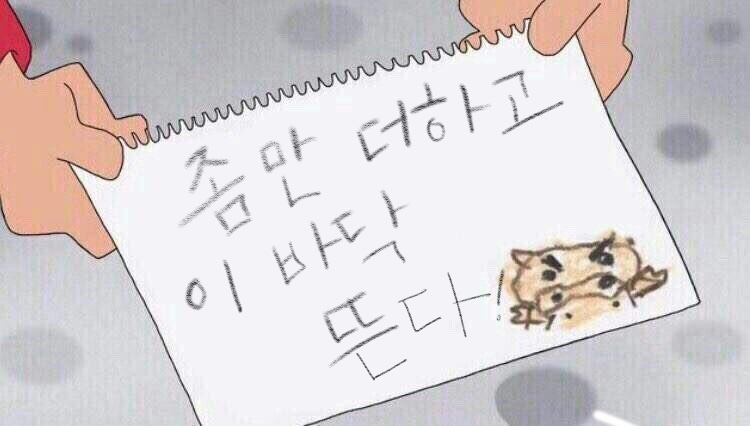

이후 친구가 말해주던 뼈때리는 한마디로 오늘 포스팅을 마무리 하겠다.

그걸....다 이해할 수 있을까?